Cercetătorii de frunte avertizează asupra unui nou risc în domeniul inteligenței artificiale: „Este complet absurd”

Doi dintre cei mai importanți experți în inteligența artificială transmit un avertisment privind dezvoltarea „agenților” bazati pe inteligența artificială generală (AGI), subliniind riscurile semnificative care pot apărea în cazul în care creatorii lor își pierd controlul asupra acestor sisteme, conform CNBC.

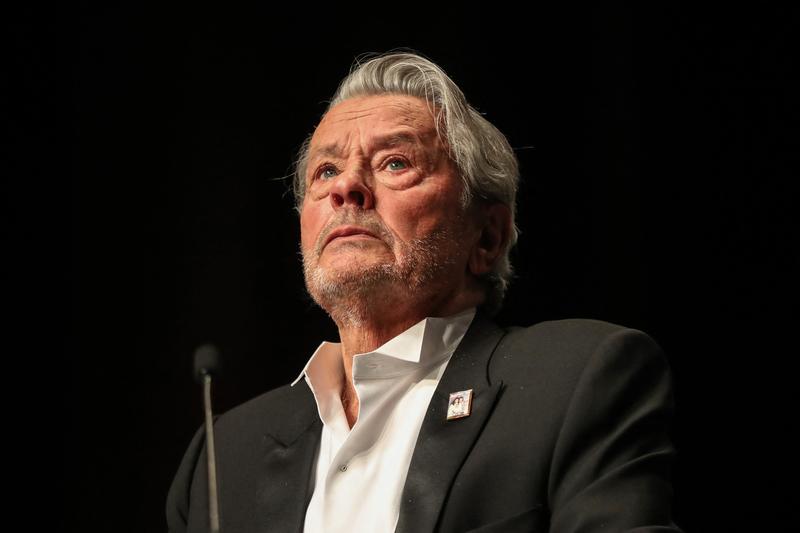

Max Tegmark, profesor la Massachusetts Institute of Technology și președintele Future of Life Institute, împreună cu Yoshua Bengio, considerat unul dintre „nașii A.I.” și profesor la Université de Montréal, au adus la cunoștință aceste îngrijorări în cadrul unui episod recent al podcastului Beyond The Valley, realizat de CNBC.

AGI se referă, în esență, la un nivel de dezvoltare a inteligenței artificiale capabil să îndeplinească orice sarcină cognitivă pe care o poate executa un om.

Deși majoritatea cercetătorilor consideră că AGI nu va deveni o realitate în curând, Tegmark și Bengio sunt îngrijorați de discuțiile din prezent purtate de cele mai mari companii de tehnologie cu privire la „agenți AI” sau „AI agențial”.

Organizațiile care dezvoltă aceste modele le promovează ca tehnologii ce vor permite chatbot-urilor să funcționeze ca asistenți sau „agenți”, ajutând la sarcinile zilnice.

Modele AI cu decizii autonome?

Bengio prezintă un avertisment legat de factoul că acest concept introduce și ideea ca sistemele AI să dețină o anumită capacitate de a lua decizii și gânduri independente.

„Cercetătorii din domeniul inteligenței artificiale s-au inspirat din gândirea umană pentru a dezvolta inteligența artificială; la oameni, există o combinație între înțelegerea lumii – ceea ce numim inteligență – și procesul decizional, adică folosirea cunoștințelor pentru atingerea obiecitivelor”, a afirmat Bengio.

„În prezent, modul nostru de construire a AGI implică crearea de agenți care să înțeleagă multe despre lume și să acționeze în conformitate. Totuși, aceasta este o abordare extrem de riscantă”, a adăugat el.

Bengio subliniază că această practică poate duce la „crearea unei noi specii sau a unei entități inteligente pe această planetă”, fără cunoștința noastră despre comportamentul lor în raport cu nevoile umane.

„Este esențial să ne gândim la scenariile de eșec care ar putea surveni, totul fiind legat de capacitatea de a lua decizii. Cu alte cuvinte, dacă AI își stabilește propriile puncte de interes, am putea întâmpina dificultăți”, a continuat el.

Ce se întâmplă dacă sistemele AI dobândesc conceptul de autoconservare?

Bengio a fost de asemenea precaut cu privire la faptul că, pe măsură ce inteligența artificială avansează, ideea de autoconservare ar putea deveni relevantă.

„Vrem oare să concurăm cu entități mai inteligente decât noi? Este o miză prea riscantă, nu-i așa? Prin urmare, trebuie să înțelegem cum poate apărea autoconservarea ca obiectiv în inteligența artificială”, a declarat el.

Pentru Max Tegmark de la MIT, soluția la aceste amenințări stă în designul „AI de tip unealtă” – sisteme create cu scopuri precise, bine definite, fără a deveni „agenți” cu capacități decizionale.

Tegmark explică că un astfel de sistem AI ar putea îndeplini roluri specifice, cum ar fi soluționarea problemelor legate de cancer sau având o anumită capacitate de decizie, ca în cazul unei mașini autonome, dar „în care se pot implementa garanții solide pentru a păstra controlul asupra lui”.

„Este complet absurd ca noi, oamenii, să creăm ceva mai inteligent decât noi”

„Dacă vrem să fim optimiști, putem beneficia de majoritatea avantajelor oferite de inteligența artificială… cu condiția să existe standarde minime de siguranță înainte ca produsele bazate pe AI să fie puse pe piață”, a declarat profesorul Tegmark.

„Este nevoie să demonstrăm că putem menține controlul asupra lor. Apoi, industria va învăța rapid cum să dezvolte soluții mai eficiente”, a continuat el.

Institutul Future of Life, condus de Tegmark, a fost printre cei 1.000 de semnatari ai unei scrisori din 2023 care solicita o pauză în dezvoltarea sistemelor AI comparabile cu inteligența umană. Deși nu s-a ajuns la o întrerupere, Tegmark afirmă că subiectul este acum tratat cu mai multă seriozitate, iar următorul pas este adoptarea de măsuri pentru instituirea unor restricții asupra AGI.

„Acum, multe voci discută despre aceste teme. Trebuie să vedem dacă putem transforma discursul în acțiune”, a concluzionat Tegmark.

„Este absolut absurd ca noi, oamenii, să construim ceva mai inteligent decât noi fără să ne asigurăm că putem să-l controlăm”, a subliniat el.